Künstliche Intelligenz macht auch beim Bewegtbild nicht halt. Die Anwendungsgebiete sind allerdings längst nicht so überschaubar, wie bei reinen Einzelbildern oder Text-KIs. Grob kann man die Anwendungsgebiete künstlicher Intelligenz im Kontext von Bewegtbildformaten auf drei Anwendungsfelder unterteilen.

1. Generative KI:

Hier geht es konkret um das generieren von Bewegtbildern. Nach dem Hype um Midjourney und Dall E tauchten in den sozialen Netzen auch etliche Videos auf, die entweder komplett KI-generiert sind und mit Prompts erstellt wurden (text to video), als auch sogenannte video-to-video-Inhalte. Hier nimmt man ein bestehendes Video und lässt die KI die Bildinhalte nach Wunsch (und eingegebenen Prompts) umgestalten. Basis bleibt aber hier der Bildaufbau des Source-Videos. Die bewegten Inhalte sind oft noch nicht perfekt oder fotorealistisch, was vor allem auf ein Flimmern im Bild zurückzuführen ist. Schaut man diese Videos an, sieht man fast immer, dass sich Bildinhalte im Laufe des Videos verändern.

Damit wir den Hintergrund verstehen, noch einmal kurz dazu, was Film letztlich ist: Ein Film besteht aus 25-30 Einzelbildern, die innerhalb einer Sekunde abgespielt werden. Etwa ab 17-18 Bildern pro Sekunde „sieht“ unser Gehirn eine Bewegung statt eine Abfolge von Einzelbildern. Ein einminütiges Video hat also mindestens 1500 Einzelbilder.

KI generieren die Inhalte Bild für Bild. Während Einzelbilder z.B. von Midjourney schon enorme Qualität aufweisen, wirken die Videos zwar schon jetzt künstlerisch und visuell spannend, aber meist auch inkonsistent. Hier liegt ein Fokus unserer Tests. Wir wollten mal schauen, wie der Status quo aussieht.

2. Unterstützende KI-Tools:

Schon Jahre vor dem jetzigen KI-Hype haben die führenden Anbieter von Bewegtbildsoftware KI-Tools in ihre Plattformen integriert. Meist handelt es sich hier um Bildanalyse-KIs, die Gesichter, Farben oder Gegenstände erkennen. Die Anwendungsgebiete sind enorm vielfältig. Generell kann man aber sagen, dass die einzelnen Tools die Arbeit an Filmen enorm beschleunigen und zuvor für kleinere und schnellere Formate unmöglich nutzbare Techniken jetzt auch für die breite Masse der Produktionsfirmen ermöglichen. Ein Beispiel: Autorotoskoping: Hierbei stellt man einen Gegenstand oder eine Person vom Hintergrund frei. Dieser Prozess ist für viele visuelle Effekte der Basisschritt. Was vorher für 1-2 Sekunden Filmlaufzeit durchaus einen ganzen Tag manueller Arbeit gekostet hat, ist heute in wenigen Minuten erledigt. Einige neue Funktionen sind Autoedit (Premiere: automatisch angelegter Schnitt von Multicams) oder das neue Relight in Davinci (ein Tool, mit dem man die Beleuchtung einer Szene virtuell im Nachgang verändern kann).

3. KI-basierte Tools, die eigentlich nicht für Bewegtbildformate gedacht sind, aber auch hier kreative Möglichkeiten schaffen.

Ein Beispiel ist D-ID. Die eigentliche KI generiert auf Basis einer Audio-KI vorher programmierte Mundbewegungen in einen Avatar. Ein weiteres Beispiel ist LUMA AI. Die KI kann hier aus einem Video ein dreidimensionales Abbild der gefilmten Umgebung erstellen, mit dem man dann einen virtuellen Drohnenflug animieren kann. Und zuletzt Wonderdynamics: Mit diesem browser-basierten Tool kann man a) Motion Captures erstellen, b) Den Hintergrund clean ohne das freigestellte Objekt rendern (Backplate) und c) einen 3D-Charakter anstatt des Protagonisten einsetzen, der sich auch vom Lichtverhältnis in das Bild einfügt. Auch diese KI eher für 3D-Objekte, 3D-Erkennung gedacht, macht aber spannende Möglichkeiten auch für Motion Designer auf.

Der Vollständigkeit halber ist sind natürlich Midjourney und ChatGPT ideal für ein Brainstorming, Proof of Concept und für die Erstellung von Stories und Storylines.

FAZIT:

Die jetzigen Möglichkeiten für Bewegtbildproduktion sind schon jetzt beeindruckend. Und die Geschwindigkeit, in der sich die Qualität der einzelnen Tools verbessert, kann man schon fast in Wochen statt in Monaten beschreiben.

Für die Unternehmenskommunikation werden diese Tools in naher Zukunft beeindruckende Möglichkeiten eröffnen, schnell und kostengünstig bewegte Inhalte zu erstellen oder erstellen zu lassen.

Vor allem das prompten von Stocksequenzen wird eine interessante Alternative zu jetzigen Stockdatenbanken sein.

Auch das Erstellen von Motion Design oder Animationsfilmen wird bemerkenwerte Alternativen durch KI-Formate sehen. Ein Beispiel ist hier die Corridor Crew, die mit Stable Diffusion und dafür selbst trainierten Modellen schon einen kompletten Vampire-Animationsfilm erstellt hat:

Indirekt profitiert die Unternehmenskommunikation von den Tools, die Profis einen schnelleren Workflow in der Postproduktion ermöglichen. Hier werden Bearbeitungszeiten teilweise um die Hälfte oder mehr reduziert, was sich am Markt in geringeren Kosten zeigen wird. Ausserdem können kreativere Formate realisiert werden, die zuvor nur großen Filmproduktionen mit mindestens 6-stelligen Budgets vorenthalten bleiben.

Die KI-Bewegtbildinhalte verändern aber schon jetzt auch die sozialen Kanäle. KI-Videos schiessen wie Pilze aus dem Boden und erzeugen neue Trends, die – wenn passend für das Unternehmen – auch neue Kommunikationsansätze ermöglichen.

Letztlich sind viele Tools noch in den Kinderschuhen, aber die Entwicklung ist rasant. Wir sind gespannt, was in den kommenden Monaten passieren wird.

Zu den Tools im Einzelnen:

Lumalabs

Luma AI – NERF Rendering

Ein Tool mit dem mit einem einfachen Smartphone-Video ein nahezu fotorealistischer 3D-Scan von Menschen und Situationen erstellt werden kann. In der Kommunikation ist Luma AI ideal für Personen- oder Teamportraits. Auch für Events, neue Produktvorstellungen oder HR-Kommunikation kann man mit der kostenlosen APP spannenden Content erstellen. Durch eine automatische Freistellung des Zielobjektes ist es möglich, vom Hintergrund freigestellte 3D-Objekte zu erstellen. Das kann in Zukunft spannend für die Nutzung in VR/XR-Anwendungen werden.

In der Praxis erstellt man ein Video, bei dem man sich 3 mal um das gewünschte Objekt oder die gewünschte Person im Kreis herum bewegt. Alle Objekte im BIld müssen unbeweglich sein. Will man Portraits erstellen, müssen alle Beteiligten also für zirka 30 Sekunden „stillhalten“. Fahrende Autos oder Menschen die durchs Bild gehen sind also prinzipiell nicht möglich, erzeugen aber manchmal spannende Bildfehler und eher „künstlerische“ Scans.

In der Nachbearbeitung kann man verschiedene virtuelle Drohnenflüge um das Objekt als Video erstellen oder sich mit dem Smartphone „AR-artig“ in der Szenerie bewegen.

Künstliche Intelligenz wird hier genutzt, um aus einem Video alle Daten zu extrahieren, die für ein 3D-Abbild des Ortes nötig sind. In der App kann man in verschiedenen Ansichten auch den dreidimensionalen „Mesh“ des Ortes ansehen.

Fazit:

– einfaches Tool mit spannenden Ergebnissen

– gut für Einsteiger ohne Vorkenntnisse

– ein normales Smartphone und etwa 30 Sekunden Video reichen aus

– kostenlos nutzbar

Stable Diffusion

Warpfusion generative AI Video

Stable Diffusion:

Stable Diffusion als Basis-KI ist die am weitesten fortgeschrittene Plattform für bewegte generative KI-Anwendungen (und auch ein Konkurrent für Plattformen wie Midjourney oder Dall E für Einzelbilderstellung). Viele der derzeit im Videobereich trendigen Apps nutzen Stable Diffusion als Basis für Ihre Anwendungen. Als kostenlose Open Source Plattform ist es auch möglich, das KI-Modell auf eigenen lokalen Rechnern zu installieren oder über Cloudanwendungen zu nutzen. Das schafft viele Möglichkeiten, beispielweise das KI-Training auf bestimmte Personen oder Grafikstile, die dann über Prompts angewendet werden können oder – hier eher für Experten – das eigene Coding.

Warpfusion:

Ein Vorteil des Open Source Ansatz von Stable Diffusion ist die große Community, die sich – zumeist in Discord-Channels – miteinander austauschen und optimierte Modelle und Notebooks sharen. Basis eines derzeitigen Tiktok-AI-Contest ist beispielweise Warpfusion. Im Contest werden Tanzvideos von Usern in bewegte griechische Mamor-Statuen verwandelt. Neben dem generellen Look geht es hier auch darum, wer das stabilste Rendering durch Settings und Prompts generiert, sprich wer das Video erstellt, dass die wenigstens Bildstörungen erzeugt.

Grundlage von Warpfusion ist immer ein Basis-Video, dass von der KI analysiert wird. Durch Settings, die den Bildstil und die Stärke der Bearbeitung ermöglichen und selbstverständlich Prompting kann das analysierte Video beliebig verändert werden. Auf diese Weise haben einige User bereits komplette Animationsfilme im Stable Diffusion Stil umgesetzt.

Ein weiterer Vorteil ist der personalisierte Bildstil, der über sogenannte Checkpoints generiert wird. Ein Checkpoint ist von anderen Usern trainiertes Modell. Checkpoints kann man auf Plattformen wie „Huggingface.co“ teils bezahlt, teils unbezahlt downloaden.

Arbeiten mit Stable Diffusion/Warp Fusion:

Die Plattform erzeugt unseres Erachtens die derzeit besten bewegten Inhalte. Sie ist aber auch die anspruchsvollste in der Nutzung. Man muss sich mit diversen Parametern, Interfaces und Arbeitsweisen vertraut machen. Dafür wird man aber auch mit inspirierenden Output belohnt.

Generell muss man sich ein Google Colab Notebook installieren. Das ist kostenlos möglich, oder für zirka 10 Euro pro Monat mit mehr Rechenkapazität.

Danach kann man sich ein virtuelles Notebook in das Colab laden, dass bereits alle nötigen Daten eines der zahlreichen Stable Diffusion Modelle enthält.

Im Programmierinterface kann man jetzt sogenannte Checkpoints (auf einen Bildstil programmierte Modelle) und LORAs (Beispielsweise auf eine Person individualisierte Modelle, die über spezielle Prompts abgerufen werden können) installieren.

Ab diesem Punkt muss man praktisch nur noch ein Video in die Plattform laden und kann es dann über Prompting in einen gewünschten Bildstil bringen. Auch hier muss man Geduld mitbringen. Je nach Video variieren die Ergebnisse von genial bis unbrauchbar. Minimale Änderungen in den rund 100 Einstellungsmöglichkeiten und leichte Veränderungen des Prompts können hier zu komplett unterschiedlichen Lösungen führen. Das Interface ist auch in Python-Programmiersprache und nicht intuitiv grafisch, sodass eine Onlinerecherche zwingend notwendig ist, um zu Ergebnissen zu kommen.

Anwendungsfelder:

– Bilderzeugung

– Videogenerierung rein über Prompts oder sogar mit kleinen zeitlich definierten Prompts

– Videogenerierung mit einem Source-Video, dass mit Prompts verändert wird

Einsatzgebiete:

– Storyboarding

– Animations- und Motion Design Filme

– moderne “Add-ons“ und Bildstile die im normalen Motion Design Workflow genutzt werden können

– Proof of Concept und Brainstorming (Ideen antesten, greifbar machen)

– Generierung eigener Stockclips

Nutzen für die Unternehmenskommunikation:

Derzeit sind die Ergebnisse noch recht „kunstvoll“ und nicht 100% steuerbar. Für Social Media Clips, die Aufmerksamkeitsstark sind oder einzelne, eher leichte Themen sind die Ergebnisse schon nutzbar. Perspektivisch werden derartige Videos eine interessante Alternative zu Stockplattformen sein.

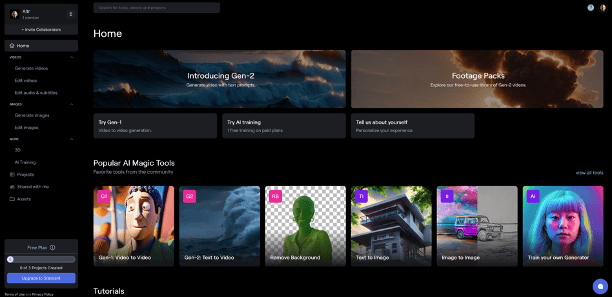

Runway ML

Browserbasierte Videoediting Suite mit vielen AI-Funktionen

Runway bietet eine eigene Plattform, mit der sich diverse AI-Tools für die Bewegtbildproduktion nutzen lassen. Beispielsweise kann man eine Person freistellen, automatisch neue Hintergründe dafür mit text-to-image generieren, Subtitles aus dem Ton des Videos generieren und vieles mehr.

Besonders gehyped werden derzeit die GEN-1 und die GEN-2. Beide sind videogenerierende KIs.

Mit der Gen-1 kann man ein Video mit Textprompts oder mit dem Look eines beliebigen Standbildes verändern. Der Prozess ist ähnlich wie bei Stable Diffusion, das Interface ist aber im Vergleich kinderleicht zu nutzen.

Mit der GEN-2 kann man text-to-video erstellen. Das heisst man kann sich kleine Stocksequenzen selbst „erdenken“. Die Qualität der Gen-2 ist schon erstaunlich gut. Die Ergebnisse sind aber schwer kontrollierbar bzw. nur schwer im Detail nach eigenen Wünschen anpassbar.

Runway ist eine Plattform mit monatlichen Kosten (14€ in der Basisversion). Die Ergebnisse sind schon beeindruckend, aber für 14 Euro erhält man lediglich 72 Sekunden Rendering/Monat. Damit schafft man lediglich einen kleinen SozialMedia Post inklusive Tests.

Generell positioniert sich Runway als Alternative zu Firefly/Gingebread in den Adobe-Produkten.

Als Tool zu Erstellung von eigenen Stockfilmen kann es schon für das eine oder andere Unternehmen und im Bereich Social Media oder Präsentationsdesign interessant werden.

D-ID.com

Avatare aus Bildern und Audiospuren generieren

D-ID (in Verbindung mit einer Voice-AI)

Mit D-ID kann man ein Foto einer realen Person oder ein Avatarbild, das man beispielweise in Midjourney erzeugt hat, einen Text sprechen lassen. In der Praxis funktioniert das sehr einfach. Man spricht entweder selbst einen Text ein und lädt das Audiofile in die Plattform. Alternativ kann man eine Voice-AI nutzen und sie einen Text sprechen lassen.

Im Browserinterface kann man dann ein Standbild einer Person oder eines Avatars hochladen und auswählen.

Jetzt muss man nur noch das Video erstellen lassen und man bekommt in Minuten ein Video, in dem der Avatar den Text spricht.

Die KI analysiert hier das Audiofile und bewegt den Mund entsprechend.

Wichtig ist, das man ein Bild auswählt, bei dem der Protagonist möglichst groß im Bild ist und direkt in die Kamera schaut. Seitliche Aufnahmen erzeugen Fehler. ist die Frisur sehr lockig und wild oder trägt die Person einen Helm oder Hut können weitere Fehler auftreten. Man sollte also eher eine Person mit Zopf oder Kurzhaar-Frisur auswählen.

Die Ergebnisse sind schon beeindruckend, aber noch als KI erkennbar. Auf einem Smartphone kann man das aber schon einmal übersehen. Wenn Plattformen wie D-ID immer besser werden, stellt sich natürlich auch hier die Frage inwiefern solche Tools auch für Falschinformationen nutzbar sind, da man nur ein Bild einer Person braucht. Auch die Stimme einer Person kann man schon mit wenigen Minuten Aufnahme nachbauen und dann beliebige Texte sprechen lassen.

Trotz allem sind die Ergebnisse stand heute auch in dieser Hinsicht schon beeindruckend und ermöglichen es auch Privatpersonen, Channels rund um einen Avatar oder ein Thema zu erstellen, ohne dass Videovorkenntnisse nötig sind, oder man selbst gefilmt wird oder sprechen muss. Auch hier tauchen in den sozialen Medien viele Videos auf, in denen Privatpersonen Tutorials erstellen, ohne sich dabei selbst zu filmen.

Ein einminütiges Video für soziale Medien kann man von der Produktionszeit in knapp einer Stunde einfach schaffen. Selbst mit dem Smartphone gefilmt bräuchte man hier definitiv mehrere Stunden.

Wonderdynamics

3D-Character

Als Tool vereint Wonderdynamics Motion Capture, Blackplate-Generierung (Erstellung eines cleanen Hintergrunds ohne den Protagonisten), Lighting und Shading eines 3D-Objektes (Das ist die Basis für einen fotorealistischen Look in Hollywood-Filmen) und Rendering des Ergebnis über die Cloud (was sonst oft rechen- und zeitintensiv ist)

Konkret kann man hier ein Video hochladen, in dem eine Person sich vor der Kamera bewegt. Die Person wird analysiert und die Bewegungen können auf einen beliebigen 3D-Avatar übertragen werden (Motion Capture). Aus der Farbgebung des Bildes wird auch eine Depthmap generiert, mit der Wonderdynamics den 3D-Avatar virtuell beleuchten. So sieht er so aus, als wäre er wirklich in der Szene.

Die nachfolgenden Beispiele würden in der Praxis mehere Tage pro Video dauern. Mit Wonderdynamics kann eine Person diese Arbeit in einem Tag ohne großen Aufwand umsetzen.

Learnings: Derzeit kann das Tool nur eine frei im Bild stehenden Person erkennen. Gegenstände (wie ein Tisch vor dem Protagonisten) werden nicht erkannt und führen zu Bildfehlern.

Trotz gewisser Einschränkungen lässt Wonderdynamics erahnen, wie leicht umsetzbar in Zukunft visuelle Effekte umgesetzt werden können. Als Tools ist es nur eins von etlichen Ansätzen mit jeweils sehr spezialisierten Funktionen. In der Breite können wir aber komplexe Toolsammlungen in bestehenden Anwendungen wie Blender, Cinema 4D oder Unreal Engine erwarten, die aufwendige Effekte in Zukunft auch für kleinere Projekte möglich machen.