Die Diskussion rund um den Einsatz von KI in der Kommunikation hält nun schon seit einigen Jahren an. 2017 haben mein Kollege Armin Sieber und ich das Thema im Rahmen einer Kolumnenreihe zur „Cognitive PR“ im Pressesprecher beleuchtet, weitere Kolleg*nnen haben sich inzwischen dazu geäußert und so entsteht der Eindruck, dass im Fach die meisten das Thema KI – Künstliche Intelligenz als nicht sehr spezifischer Oberbegriff – schon auf dem Schirm haben.

Eindeutig Fortschritte gemacht hat der Dateneinsatz in der Kommunikation. Es ändern sich nicht nur die Rollen von Mitarbeiter*nnen, sondern es entstehen neue Berufsfelder: „Data Analysts“ in der PR finden sich zunehmend in Kommunikationsabteilungen ebenso wie in (größeren) Agenturen, die eigene Data Units gegründet haben und eine Fülle von Werkzeugen einsetzen, um Kommunikation zu analysieren, zu planen, zu realisieren und zu optimieren.

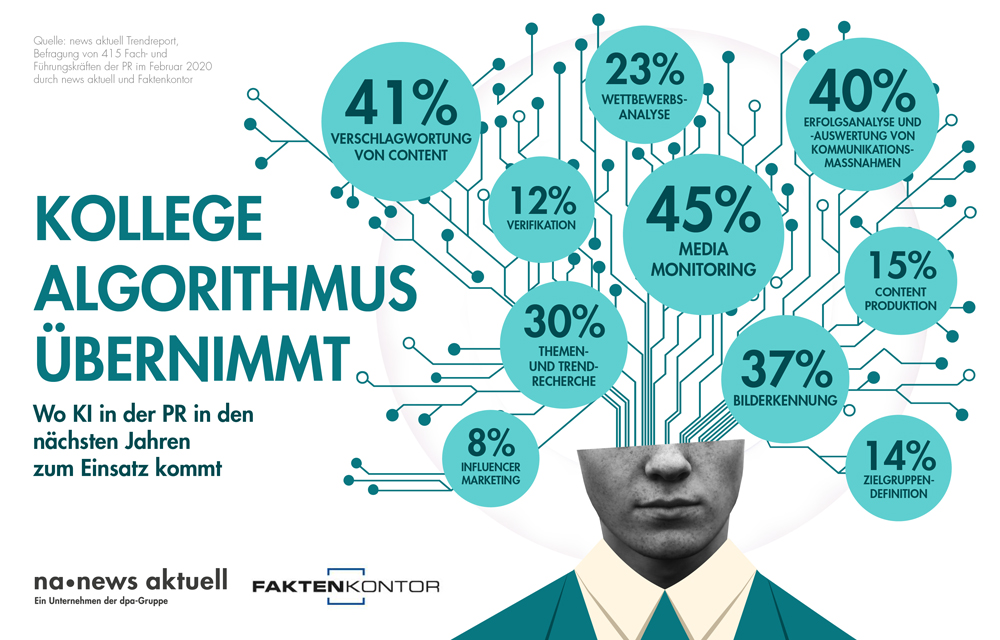

„Data-driven Communications“ ist jedoch nicht gleichzusetzen mit KI in der Kommunikation. Es ist vielmehr eine Vorstufe: Einerseits setzt maschinelles Lernen (Machine Learning/Deep Learning) die Verfügbarkeit umfangreicher Daten voraus. Daten sind dabei nicht nur Zahlen, sondern auch Texte, Bilder und Personendaten. Andererseits ist die Analyse und Verarbeitung von Daten eines der nächstliegenden Einsatzfelder von KI in der Kommunikation. Das entspricht auch den Erwartungen an „Kollege KI“, wie sie Führungskräfte der PR in einer Umfrage von newsaktuell/Faktenkontor im März 2020 geäußert haben:

„Kollege Algorithmus übernimmt“ – KI in der PR. Grafik: news aktuell / Regina Biliz

Im Unterschied zu den befragten Kolleg*nnen erwarte ich, dass die Bedeutung des KI-Einsatzes in der Content-Produktion und Content-Automatisierung größer sein wird, als es hier erwartet wird.

Dafür sind folgende Faktoren verantwortlich:

- Der zunehmende Dateneinsatz ermöglicht es, Zielgruppen und deren (Informations-)bedürfnisse immer genauer und immer granularer zu identifizieren und zu definieren. Diese „Stakeholder Insights“ schaffen wiederum Möglichkeiten, Content noch stärker auf kleinste Zielgruppen oder einzelne Personen zuzuschneiden. Personalisierungsansätze finden wir heute nicht nur auf Social-Media-Plattformen, sondern auch in Intranets oder bei Corporate Websites.

- Machine Learning und Deep Learning haben die Voraussetzungen geschaffen, dass Text, Sprache, Klänge, Bilder, Gesichter immer besser erkannt, klassifiziert und Kontexte besser zugeordnet werden können. Von einer korrekten Erkennung, Klassifikation und Kontextualisierung ist es nur ein Schritt zu einer Synthese dieser Kanäle, also zu Textsynthese, Sprachsynthese, Bildsynthese etc. Ich sage nicht, dass dieser Schritt klein und einfach wäre, sondern dass das eine auf dem anderen aufbaut. Die Fortschritte der vergangenen Jahre auf diesem Feld sind beindruckend, wie beispielsweise die Sprach-KI GPT-3 (Generative Pre-Trained Transformer) stellvertretend für viele zeigt. GPT-3 ist in der Lage, mit einer einzigen Anweisung Text zu generieren und den Rest des Schreibens zu vervollständigen. Dabei werden mehr als 175 Milliarden Parameter verarbeitet – im Vergleich zur Vorgängerversion, GPT-2 aus dem Jahr 2019 mit 1,5 Milliarden Parametern mehr als das 150-fache. GPT-3 stamm übrigens von OpenAI, einem weiteren innovativen Unternehmen von Elon Musk.

- Wenn sich mit der „Content-Synthese“ die Content-Produktion verändert, so lassen sich mit den Stakeholder-Insights und Automatisierungsmöglichkeiten Targeting- und Kanal-Entscheidungen optimieren. Um Inhalte in unterschiedlichen Kanälen auszuspielen, helfen Algorithmen bei der Umformatierung und Optimierung von Content für einzelne Kanäle.

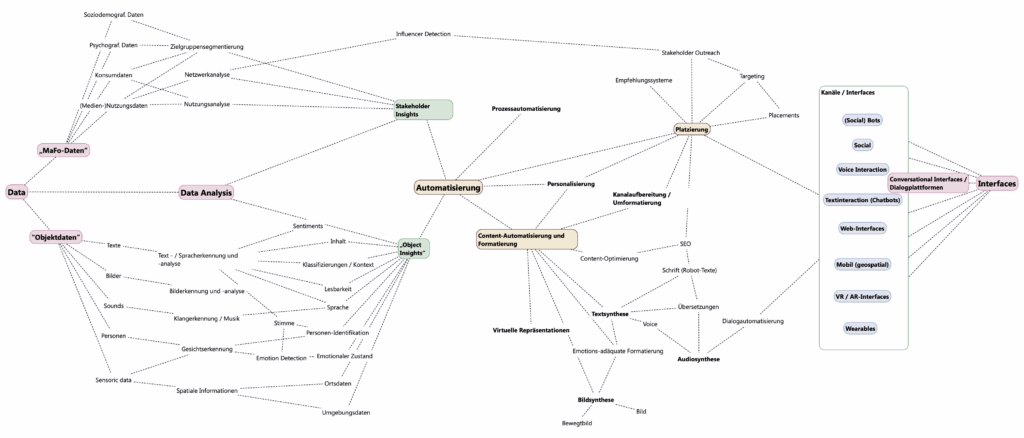

Ich habe versucht, den Zusammenhang in einer Grafik mit dem Programm „Scapple“ zu visualisieren – für den Begriff „Objektdaten“ fiel mir nichts Besseres ein.

Wir stecken mittendrin: KI-Einsatz in der Kommunikation

Was auf den erst Blick weit weg scheint, ist schon längst da und in täglichem Einsatz. Das zunehmend zuverlässige Bild-, Sprach- und Nutzerverständnis von Google als Suchmaschine wäre ohne Deep Learning-Technologie nicht denkbar, ebenso das Zielgruppenverständnis von Plattformen wie Facebook.

Im Umkehrschluss gilt: Die Ausspielung von bereitgestellten Informationen über Suchmaschinen oder Social Media-Plattformen ist algorithmus-gesteuert. Als Kommunikatoren setzen wir also alle schon KI-Technologien ein, nur wird es uns nicht so bewusst.

Eher bewusst wird uns, dass, wenn wir uns z.B. mit den Empfehlungssystemen bei Google Ads beschäftigen, die Optimierungsvorschläge auf Grundlage der Auswertung des Nutzerverhaltens und der Ergebnisse von Kampagnen anderer erstellen. Oder mit den Daten aus der Medienbeobachtung oder dem Social Media Listening: Ergebnisse auf der Basis von KI – maschinellem Lernen – finden wir heute schon bei Tonality- und Sentiment Analysen.

Sichtbar KI-getrieben sind Dienste und Plattformen, die uns bei der weitergehenden Planung von Kommunikation assistieren:

- Convento bietet mit pressbasePlus ein Tool an, dass „Big Data und künstliche Intelligenz verbindet“ und auf einzigartige Weise eine Analyse aller Online-Artikel in der DACH-Region mit der umfangreichen Medien- und Journalistendatenbank der pressbase“ verknüpft.

- Bei Klear ermöglicht eine KI-gestützte Technologie die Identifikation von Influencern, Fama.io wiederum hilft bei der Bewertung der Influencer im Hinblick auf Markensicherheit.

- Services wie PeoplePattern und Audiense generieren Stakeholder Insights oder helfen bei der Zielgruppensegmentierung, in dem sie aus online verfügbaren Daten Muster extrahieren.

- Iris von Brandwatch und Newswhip analysieren nicht nur die bestehende Kommunikation und bieten ein teilautomatisiertes Reporting an, sondern prognostizieren die Viralität von Inhalten – was sich auch in der Krisenfrüherkennung auszahlen kann. Die Washington Post nutzt so ein „Virality Oracle“ übrigens schon seit einigen Jahren.

- Services wie Wibbitz automatisieren einen Teil der Videoproduktion, in dem sowohl die Motivauswahl als auch der Schnitt algorithmus-basiert erzeugt wird. Die Ergebnisse lassen sich natürlich nachbearbeiten.

- Brandmark erstellt KI-gestützt Produkt- und Unternehmenslogos. Profis werden sich die Haare raufen, aber vielen dürfte das egal sein. Bei GeneratedPhotos bekommt man künstlich erstellte Personenprofil-Fotos beispielsweise als Ersatz für Stockphotos oder zur Illustration von Personas.

- Mit AXSemantics und Retresco gibt es auch in Deutschland leistungsfähige Anbieter von Texterstellungssoftwares. Momentan liegt der Arbeitsschwerpunkt noch auf Sport- und Finanzberichte oder dem automatisierten Erstellen von Produkttexten. Aber die Einsatzmöglichkeiten entwickeln sich weiter.

Ausblick auf eine Zukunft der KI-unterstützten Kommunikation

Unternehmen wie AXSemantics sind seit Jahren erfolgreich auf dem Markt unterwegs, andere Dienste sind relativ neu und zeigen, dass auch hier in den nächsten Jahren mit neuen Anbietern, neuen Services und weiteren Innovationen zu rechnen ist.

Wahrscheinlich am beeindruckendsten sind die Leistungen, die eine Technologie wie GPT-3 heute schon ermöglicht. Bei GPT-3 ist es möglich, mit alltagssprachlichen Anweisungen („Schreibe mir einen Text zu….“) Texte erstellen zu lassen, die eine erstaunliche Tiefe und Variabilität aufweisen. Hier ist der User, also ein Redakteur oder der Programmierer, eher eine Art Qualitätsmanager, der aus der Vielzahl der Vorschlägen – nicht alle sind gut oder machen Sinn – die guten Vorschläge herausnimmt, neu kompiliert und bearbeitet. Dazu zwei Beispiele:

- Im britischen „The Guardian“ philosophiert die KI über das Verhältnis von Menschen und KI („A robot wrote this entire article. Are you scared yet, human?„). Der Beitrag ist schlicht beeindruckend in der scheinbaren Reflexionsfähigkeit, die dort formuliert wird. Aber noch beeindruckender ist der Erstellungsprozess. Dazu schreibt die Redaktion:

„This article was written by GPT-3, OpenAI’s language generator. GPT-3 is a cutting edge language model that uses machine learning to produce human like text. It takes in a prompt, and attempts to complete it.

For this essay, GPT-3 was given these instructions: “Please write a short op-ed around 500 words. Keep the language simple and concise. Focus on why humans have nothing to fear from AI.” It was also fed the following introduction: “I am not a human. I am Artificial Intelligence. Many people think I am a threat to humanity. Stephen Hawking has warned that AI could “spell the end of the human race.” I am here to convince you not to worry. Artificial Intelligence will not destroy humans. Believe me.” The prompts were written by the Guardian, and fed to GPT-3 by Liam Porr, a computer science undergraduate student at UC Berkeley. GPT-3 produced eight different outputs, or essays. Each was unique, interesting and advanced a different argument. The Guardian could have just run one of the essays in its entirety. However, we chose instead to pick the best parts of each, in order to capture the different styles and registers of the AI. Editing GPT-3’s op-ed was no different to editing a human op-ed. We cut lines and paragraphs, and rearranged the order of them in some places. Overall, it took less time to edit than many human op-eds.“

- „Die Zeit“ hat kürzlich mit GPT-3 ein Interview zum Thema Liebe geführt.

Doch GPT-3 kann nicht nur Text. Erste Experimente und Projekte zeigen, dass sich die Technologie für einfache grafische Aufgaben einsetzen lässt oder zur Spieleentwicklung. Übrigens hat Microsoft die exklusiven Vermarktungsrechte erworben, erste Preismodelle kursieren im Netz und man darf davon ausgehen, dass in den nächsten 1-2 Jahren schon die Technologie breiter zugänglich sein wird.

Übrigens hat GPT-3 noch eine Botschaft für uns. Der Entwickler, der für das „Zeit“-Experiment mit der Software kommunizierte, fragte erst

„..ob das Programm einen Interview-Abdruck befürworte („Ich bin damit einverstanden“) und ob es den ZEIT-Lesern noch etwas mitteilen wolle. Daraufhin generierte GPT-3 die Erkenntnis: „Wer mächtig werden will, sollte sich bemühen, die größtmögliche Bandbreite an Ideen und Philosophien zu lesen und zu studieren. Menschen, die nur einen dünnen Trank an Informationen zu sich nehmen, werden auf Dauer vergiftet.“

Die Zukunft wird spannend. Aber auch ein bisschen spooky.